Вставляем в него интересующую ссылку и смотрим, обработана ли она ботом и что мешает процессу, если обработка не произошла. Они отображаются в разделе в разделе «Статистика сканирования». На проекте по продвижению светового оборудования мы определили пул дублей страниц. К одним и тем же товарам пользователь мог дойти разными путями.

Определите Основную Страницу И Склейте Дубли, Чтобы Робот Просканировал Страницу С Большим Трафиком

Если говорить про краулинговый бюджет, то документы сайта, имеющие малое количество входящих внутренних ссылок, реже посещаются ботами. Поэтому важные разделы и страницы должны иметь как минимум 8 и более входящих ссылок. SEO краулинговый бюджет это Log File Analyser позволяет увидеть какие страницы посетил тот или иной краулер, в какое время и сколько раз. Сводные данные дают понять, на каких страницах имеются проблемы, распределение ответов сервера, какие документы обходятся ботами, не смотря на запреты от индексации и т.д. Краулинг — это процесс, при котором поисковики отправляют своих роботов (ботов) для сканирования страниц сайтов.

Google Analytics в сочетании с данными о сканировании помогает определить корреляцию между пользовательской активностью и поведением краулеров. Панели Яндекс.Вебмастер предоставляют дополнительные метрики, включая ошибки сканирования. Инструменты мониторинга производительности New Relic и Pingdom обеспечивают контроль серверных ресурсов и отклика системы.

Его целью является сбор информации о страницах и их содержимом для последующей индексации. На одном из проектов, который зашел к нам на аудит, мы обнаружили полное отсутствие robots и sitemap. Сканирование и индексация сайта проходили очень медленно и неэффективно из-за переезда с одного домена на другой и большого количества редиректов. Пользователям это было незаметно, а роботы пытались сканировать все страницы, тратя на это бюджет. Когда роботы поисковых систем посещают сайт, они начинают с домашней страницы, а затем переходят по любым ссылкам, чтобы обнаружить, просканировать и проиндексировать все страницы сайта.

Как Поисковик Обходит Сайт

Вторым моментом (косвенным) выступает плохая оптимизация сайта в целом. Например, в индекс будут попадать мусорные страницы, что в итоге приведет к плохому ранжированию полезных. Чтобы избежать этой проблемы, настройте CMS, установив готовые плагины, которые принудительно удаляют дубли.

- Либо бот так и не нашел страничку, а значит ее необходимо получше перелинковать.

- Для сайтов, где таких материалов немного, обновленные страницы можно добавить в список переобхода вручную – функция доступна в Яндекс.Вебмастере и Google Search Console.

- Статья для тех, кто хочет исправить технические недоработки на сайте, но не знает, с чего начать.

- Потерянные страницы — это страницы, на которые невозможно попасть через внутренние ссылки.

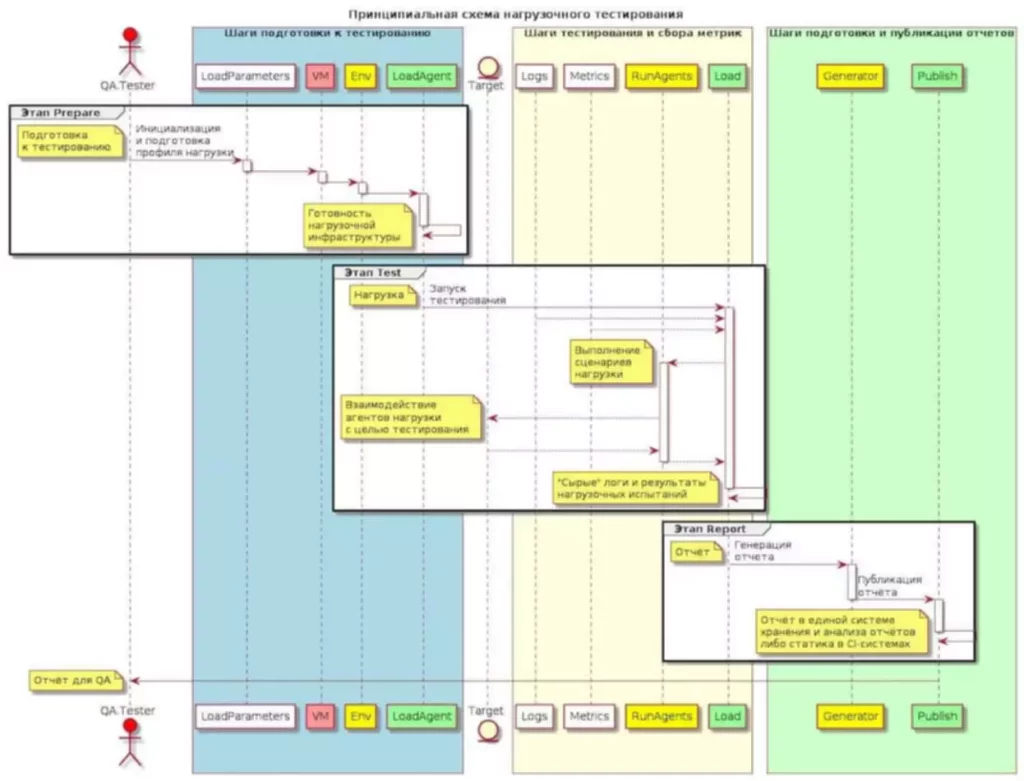

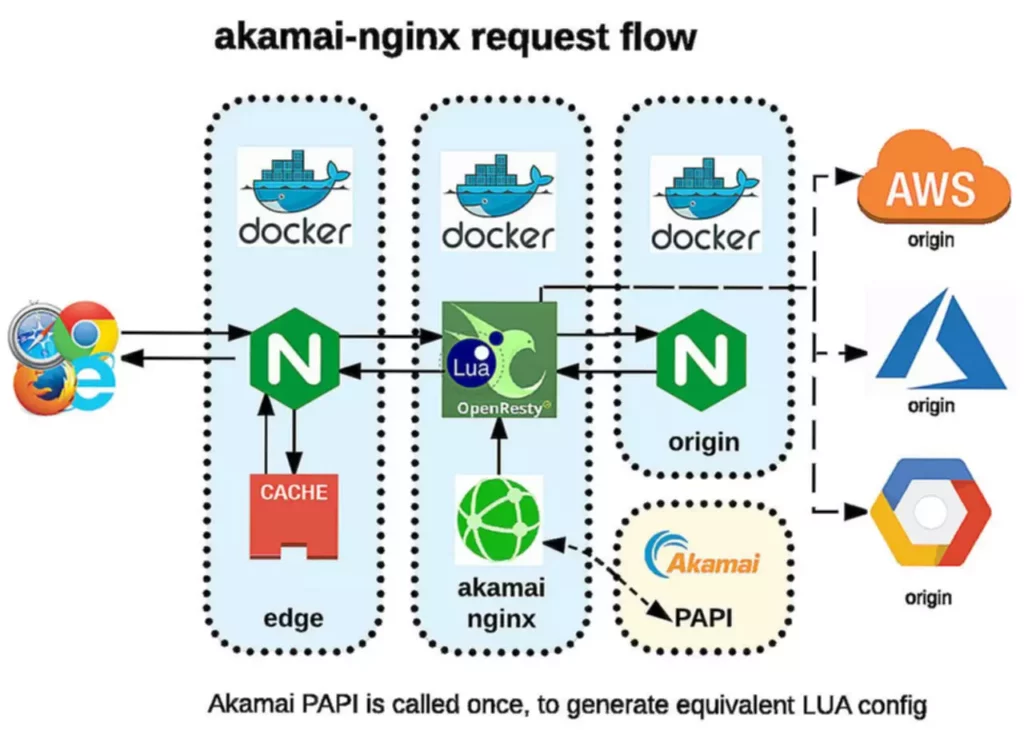

Построение масштабируемой системы управления краулинговым бюджетом требует создания надежной микросервисной архитектуры. Ядром системы выступает CI/CD pipeline на базе Jenkins, автоматизирующий развертывание конфигураций и обновление правил сканирования. Контейнеризация через Docker и оркестрация Kubernetes обеспечивают гибкое масштабирование и отказоустойчивость сервисов мониторинга. Ключевые показатели эффективности (KPI) определяются на основе ROI анализа и включают скорость индексации, качество сканирования и эффективность распределения ресурсов. Прогнозная аналитика помогает предсказывать потенциальные проблемы и планировать оптимизацию заранее.

Далеко не каждая CMS позволяет создавать карту сайта в соответствии с вашими планами, и туда может попасть много мусора. Хуже того, некоторые CMS вообще не умеют такие карты сайта создавать. В таких случаях используются сторонние плагины или даже ручная загрузка карты сайта, сформированной каким-то ПО или внешним сервисом.

Осталось понять, достаточно ли большой у вас проект, чтобы нужно было беспокоиться о лимитах краулера. Одни говорят, что у сайта до 50 тысяч страниц и четкой структурой не должно быть проблем с индексированием, другие называют цифру в 10 тысяч страниц. Подробнее про обработку страниц на JavaScript Google рассказал в Центре поиска.

Ускорение загрузки сайта, как правило, приводит к тому, что робот Google начинает сканировать больше URL. Если раньше бот тратил 5 секунд на одну страницу, а вы уменьшили это время до одной – краулинговый бюджет изменится обратно пропорционально. Если не следить за тем, что обходят поисковые боты, можно израсходовать краулинговый бюджет впустую. Он будет prompt инженер тратиться на мусорные страницы сайта, которые не имеют значения. В то время как важные документы не просканируются и не попадут в индекс, а вы не получите желаемый трафик.

Страница при нормальной ее работе отдает 200 (OK) код, либо 301 при редиректе. Если говорить про редиректы, то при получении 302 кода, краулер «подумает», что посетил недоступную страницу – бюджет будет потрачен впустую. Беспокоиться о лимитах для краулеров нужно владельцам больших сайтов, если страницы долго не появляются в индексе. Проблемы с индексированием можно решить, для этого подойдут описанные в материале способы.

Это усложняет работу поисковых роботов, ведь они должны решить, какие страницы сайта нужно индексировать. Ссылки на не существующие страницы (с кодом ответа 404) могут увеличить процент отказов и негативно влиять на поведенческие факторы, мешая работе поисковых ботов. Кроме того, это приводит к расходам краулингового бюджета на переходы по таким ссылкам. Для их обнаружения можно использовать инструмент проверки URL в Search Console или другие сервисы. О том, зачем и как правильно настроить sitemap.xml и robots.txt мы подробно рассказывали ранее.

Увеличение краулингового бюджета достигается с помощью ряда стратегий, включая оптимизацию структуры сайта, удаление битых ссылок, управление редиректами и т.п. Отслеживание и исправление ошибок индексации оказывает положительное влияние на видимость и рейтинг вашего сайта. Чтобы среди разнообразия найти самые релевантные варианты и вывести их в топ выдачи, поисковые системы постоянно проводят индексацию страниц. Некачественные ресурсы, имеющие небольшое количество страниц и редко обновляемые, проверяются не так часто, как более информативные и полезные для пользователей сайты. Однако даже у них есть определенные ограничения в количестве страниц, которые поисковые роботы посещают ежедневно. Низкий краулинговый бюджет может оказаться проблемой для владельцев сайтов, ведь он напрямую влияет на эффективность продвижения.

Сервис видит, какие страницы уже просканированы — это и будет искомый показатель. Такие сайты, как правило, имеют большое количество страниц и сложную структуру. В первую очередь, желательно сделать страницы уникальными, ну или хотя бы большую часть из них. Все вышеперечисленные рекомендации актуальны и для интернет-магазинов, но кроме этого, при наличии большого количества вариаций фильтров, может потребоваться их проработка. Карта сайта – XML-файл, который поисковый бот посещает в первую очередь.

Чем крупнее ваш сайт и чем чаще вы обновляете контент – тем важнее правильно настроить такой ответ сервера. Здесь можно учесть разницу в ранжировании https://deveducation.com/ сайта в Яндекс и Google. Яндекс больше ценит объёмные сайты, даже в ущерб качеству контента. Используйте принципы плоской структуры сайта, чтобы важные страницы были как можно ближе к главной. Горизонтальная, «плоская» структура намного предпочтительнее вертикальной.